Auf Deine Leseliste in Meine Fotoschule setzen

Auf Deine Leseliste in Meine Fotoschule setzenIn Zusammenarbeit mit

In dem heutigen Artikel möchte ich der Bitte nachkommen, ein wenig mehr Hintergrundwissen zum Thema Bildrauschen zu bringen. Ich werde Dir erklären wie es entsteht, wie es wirkt, wie man es beseitigt und vor allem, warum es ein viel geringeres Problem ist, als vielfach angenommen wird.

Doch eins nach dem anderen. Im ersten Schritt werde ich Dir in Kurzform erklären, wie ein Bildsensor funktioniert. Dieses Grundverständnis ist nötig, um zu verstehen, wie Rauschen entsteht und wie es beseitigt/reduziert wird.

Einfach fotografieren lernen mit unseren Online-Fotokursen

Für nur 6,99€ im Monat kannst Du auf über 70 Online-Fotokurse zugreifen. Lerne die Grundlagen der Fotografie - verständlich und mit vielen Praxisbeispielen. Inklusive Test und Fotokurs-Zertifikat.

Mehr Infos zu den Fotokursen

Der Bildsensor

Die typischen Bildsensoren in Digitalkameras haben meist eine Größe im Bereich von ca. 12 x 20 mm bis 24 x 36 mm. Sie sind also kaum größer als eine Briefmarke. Auf diesen Sensoren finden sich heutzutage oft 20 – 50 Millionen (!) einzelne Pixel, von denen am Ende jedes einzelne Pixel einen späteren Bildpunkt repräsentiert. Aus diesen Zahlen wird schnell deutlich: Es geht sehr eng auf dem Sensor zu. Wir bewegen uns im Bereich von µm (Mikrometer – also millionstel Meter).

Zusätzlich befinden sich auf dem Bildsensor noch die Signalverstärker (und zwar pro Pixel je einer), die Farbfilter und Mikrolinsen und natürlich alle nötigen Leitungen, um die Signale der Pixel an den Bildprozessor der Kamera weiterzuleiten. So ein Bildsensor ist also eine hochkomplexe Angelegenheit, der sich mit modernsten Mikroprozessoren vergleichen lässt.

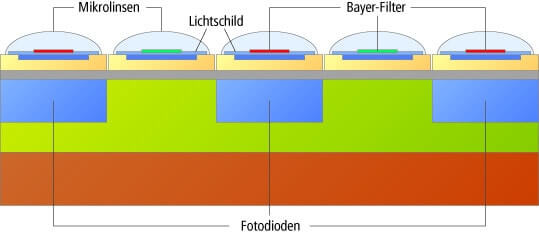

Mikrolinsen und Bayer-Pattern

Das einzelne Pixel eines Sensors ist von der Funktion her mit dem einzelnen Silberkorn des analogen Films zu vergleichen. So wie das einzelne Korn nicht farb-, sondern „nur“ lichtempfindlich ist, verhält es sich auch mit dem Pixel.

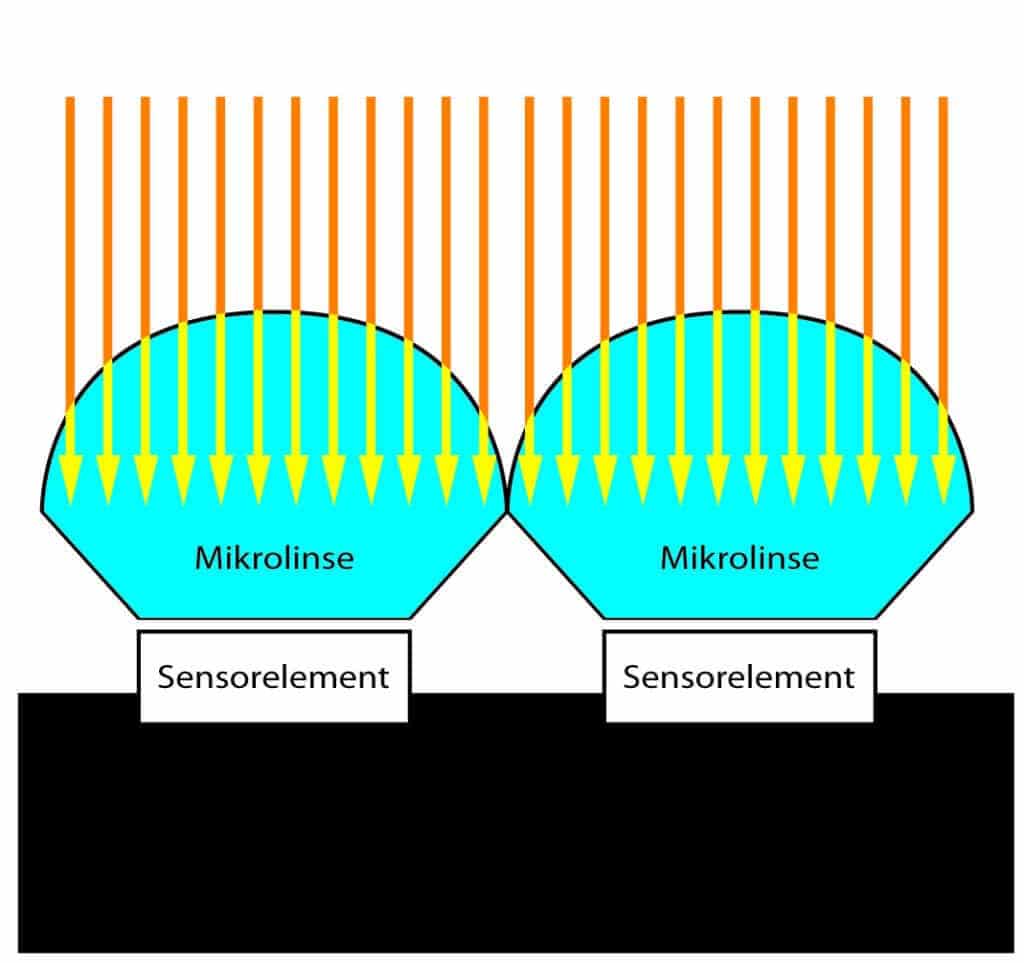

Es werden nur Helligkeitsunterschiede aufgezeichnet und gemessen. Kleine Mikrolinsen (Weitwinkellinsen) vor dem jeweiligen Pixel bündeln das Licht und verbessern die Lichtausbeute um bis zu 300%. In Qualität und Genauigkeit können die Mikrolinsen übrigens durchaus mit ihren großen Kollegen in den Objektiven konkurrieren. Sie setzen allerdings auch der Fertigung enge Grenzen, denn je höher die Auflösung auf den Chips wird, desto kleiner müssen diese Linsen gefertigt werden.

Hinter den Linsen befinden sich Farbfilter in den Farben Rot (25%), Grün (50%) und Blau (25%) – RGB. Die Anordnung der Farbfilter wird auch Bayer-Pattern genannt (die Namensgebung erfolgt in Anlehnung an den Erfinder des Patterns Bryce E. Bayer, der diese Anordnung 1975 für die Firma Kodak entwickelte). Der höhere Grünanteil wurde dem Sehvermögen des menschlichen Auges nachempfunden. Die Farbfilter selbst lassen nur die Helligkeitswerte der jeweiligen Farbe durch, der Signalprozessor bildet daraus erst wieder ein Farbbild.

Das Bayer-Pattern

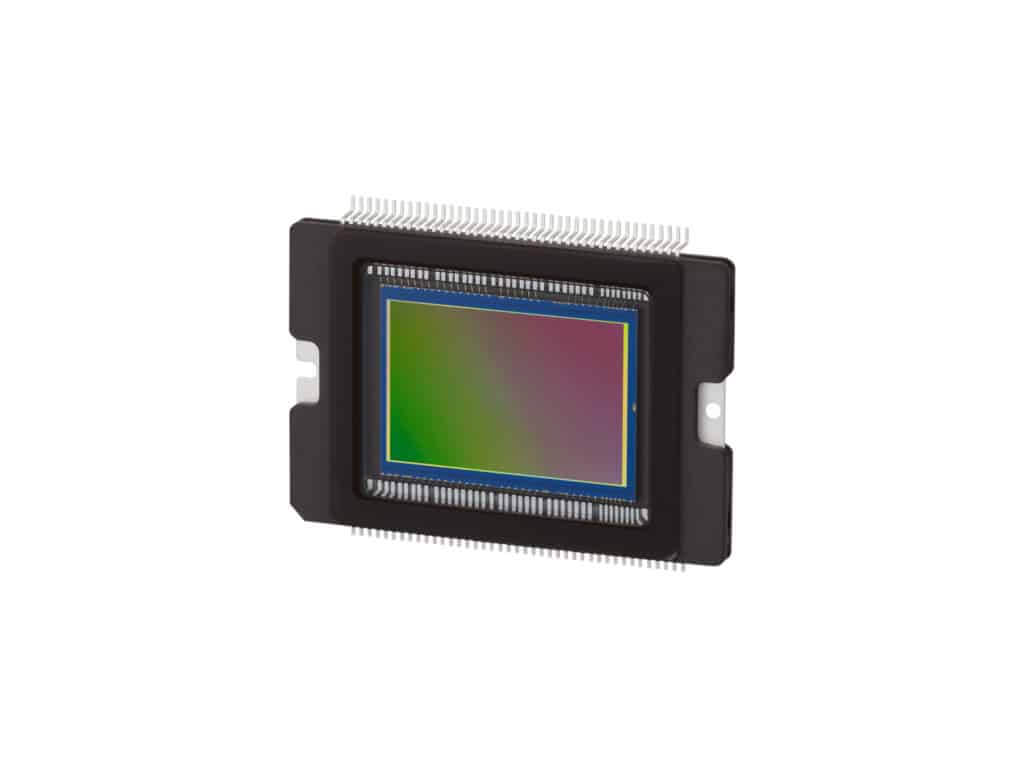

Der eigentliche Sensor ist vom Typ CMOS – Complementary Metal Oxide Semiconductor oder zu Deutsch: komplementärer Metalloxid–Halbleiter. Diese Halbleiter-Art wird heutzutage überall eingesetzt. Der CMOS-Sensor bildet den zentralen Baustein Digitalkamera und bestimmt neben der verwendeten Optik die erreichbare Bildqualität.

Die CMOS-Sensoren sehen unscheinbar aus, ohne Mikroskop ist der komplexe Aufbau aus Pixeln, Farbfiltern, Mikrolinsen, Tiefpass usw. nicht zu erkennen (Foto: Canon).

Der Vollständigkeit halber möchte ich erwähnen, dass es nicht nur das Bayern-Pattern gibt. Fujifilm verwendet eine andere Anordnung der Farbfilter (X-Trans-Sensoren) und Sigma produziert zum Beispiel den Foveonsensor, bei dem die Grundfarben nicht neben, sondern hintereinander in Ebenen angeordnet sind.

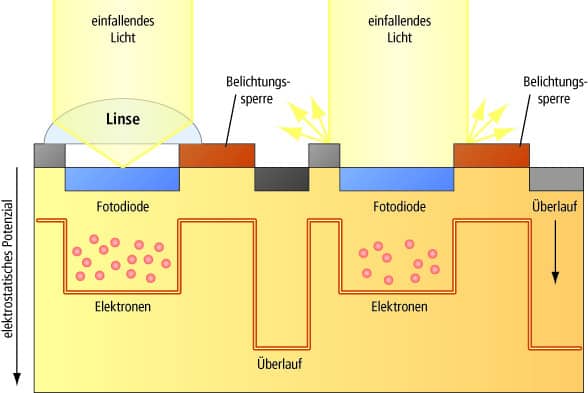

Wie funktioniert nun so ein Pixel?

Durch das Objektiv fällt Licht ein, dieses Licht wird durch die kleinen Linsen gesammelt und trifft durch den Farbfilter auf das Pixel. Der Farbfilter lässt nur Licht einer Farbe durch (damit daraus später wieder ein Farbbild generiert werden kann). Das Licht hat eine gewisse Energie und diese Energie sorgt dafür, dass sich in dem Pixel Elektronen sammeln. Je mehr Licht eintrifft, desto mehr Elektronen sammeln sich in dem Pixel und sorgen für eine elektrische Ladung.

Stell Dir am besten einen Eimer vor, der sich mit kleinen Kugeln füllt. Ist der Eimer leer, dann entspricht die „Ladung“ schwarz (kein Licht ist auf den Pixel gefallen). Ist der Eimer randvoll, dann entspricht die „Ladung“ weiß (es ist sehr viel Licht auf den Pixel gefallen (bzw. maximale Helligkeit in Rot, Grün, Blau) und alle Füllzustände dazwischen entsprechen den Helligkeitsstufen zwischen weiß und schwarz.

Ist der Prozess der Ladung abgeschlossen, kommt jemand und wiegt die Eimer. Er notiert sich die Position, an der der Eimer gestanden hat und gibt die Information weiter (an den Bildprozessor, der daraus ein Foto macht). Hört sich erst einmal einfach an oder?

Es gibt jedoch ein kleines Problem

Nun passiert leider folgendes: Auch wenn die Eimer nach jedem Wiegen leer sind, sind sie leider nie ganz leer. In dem ganzen System schwirren „freie“ Kugeln (bezogen auf das Pixel: Elektronenladungen) umher, die sich mehr oder minder zufällig auf die Eimer verteilen, egal ob Licht eingefangen wurde oder nicht. Eine gewisse Zahl dieser „freien“ Kugeln“ ist immer da und einige weitere entstehen durch Wärme (ein warmer Sensor rauscht deutlich mehr, als ein kalter Sensor).

Wird nun nach der Belichtung der Sensor ausgelesen (der Füllstand der Eimer gemessen), weichen die Messungen um die Zahl der zufällig in den Eimern befindlichen Kugeln ab.

Für helle Bereiche (viel Licht) ist diese Abweichung nur ein geringes Problem, da die geringe Zahl der zufälligen Ladungen nur einen Bruchteil der Gesamtladung ausmachen und daher das gemessene Signal nur unbedeutend verändern.

Anders verhält es sich mit den Bereichen der tiefen Schatten. Die zufällige Ladung verändert wesentlich die durch das einfallende Licht in dem Pixel entstehende Ladung (Anzahl der Kugeln im Eimer).

Es ist bei der Verstärkung und Auswertung des Signals daher kaum möglich, den Anteil der Ladung durch Belichtung von dem Teil der Ladung durch das Rauschen zu unterscheiden. In den dunklen Bereichen tritt das Rauschen daher deutlich sichtbarer auf, als in den hellen Bereichen.

Und was haben die ISO damit zu tun?

Du hast sicher diese Erfahrung gemacht: Wenn Du die ISO-Empfindlichkeit erhöhst, nimmst das Rauschen zu. Je höher die ISO, desto stärker wird das Rauschen. Ich möchte Dir erklären, woran das liegt.

Ich vereinfache die Ausführungen etwas. Bei ISO 100 ist der volle Pixel vergleichbar mit dem vollen Eimer, in den insgesamt zum Beispiel 5.000 Kugeln passen. Wenn bei der Auswertung 5000 Kugeln gefunden werden, wird das Pixel als weiß gespeichert. Ist der Eimer halb voll (2.500 Kugeln), dann wird ein mittleres Grau angenommen (wir gehen hier von einer Linearität der Ladungen aus in Abhängigkeit vom Licht). Sind keine Kugeln drin, wird der Pixel als schwarz gespeichert (und all die anderen möglichen Zwischenstufen entsprechend).

Erhöhe ich jetzt die ISO auf zum Beispiel ISO 200, dann fällt dadurch nicht mehr Licht auf den Sensor und er kann auch nicht mehr Ladungen sammeln. Ich verschiebe einfach die Bewertung der Füllstände. Halbvoll (2.500 Kugel), wird als weiß gewertet, viertel voll (1.250 Kugel) als mittleres Grau und leer bleibt schwarz. Und so geht es fort bis in die höchsten ISO-Einstellungen.

Das Problem des zufälligen Rauschens

An sich funktioniert dieses Verfahren der Signalverstärkung sehr gut. Leider ist es aber so, dass das zufällige Rauschen (also die zufälligen Ladungen in dem Pixel) nicht weniger werden, sondern gleichbleiben. Sie werden also bei höheren ISO immer stärker mitverstärkt. Während sie bei ISO 100 kaum eine Rolle spielen (selbst in schwarz), weil der Signal-Rauschabstand (so der Fachbegriff) ausreichend hoch ist, wird dieser Abstand bei hohen ISO immer geringer und erreicht bei sehr hohen ISO-Werten sogar die hellen Töne.

Die einfachste Methode wäre nun die niedrigen Ladungen, die mit dem Rauschen durchsetzt sind, zu verwerfen. Man würde sozusagen festlegen, dass nicht ein leerer Eimer schwarz als Messwert ergibt, sondern schon, wenn nur 100 Kugel (oder weniger drin sind). Tatsächlich kann so das (sichtbare) Rauschen deutlich reduziert werden, aber die Schattenbereiche des Fotos würden komplett die Zeichnung verlieren und keine Details mehr zeigen, sondern nur noch glatte schwarze Flächen.

Und warum soll das alles jetzt eigentlich kein Problem mehr sein?

Rauschen existiert und es ist technisch nicht möglich Rauschen völlig zu verhindern. Man kann es durch Kühlelemente deutlich reduzieren (wird in der Astrofotografie gemacht). Diese Verfahren ist für die normale Digitalkamera aber viel zu teuer und aufwendig.

Viel wichtiger sind andere Effekte. Zum Beispiel ist es in den letzten Jahren gelungen, Pixel so zu bauen, dass sie viel mehr Ladungen einsammeln können als früher. Bei der EOS 7D von Canon lag der Maximalwert bei ca. 17.000 Ladungen pro Pixel, bei der EOS 7D II liegt er bei deutlich über 30.000 Pixel. Allein schon durch diese Verbesserung vergrößert sich der oben angesprochene Signal-Rauschabstand deutlich. Das Rauschen wird erst bei höheren ISO sichtbar (ist aber natürlich weiterhin immer vorhanden).

Zudem werden die Prozessoren immer leistungsfähiger. Ein Signalprozessor (also der, der die Daten des Bildsensors nachher verarbeitet) in der kleinsten Digitalkamera ist derart leistungsfähig, dass man mit ihm von der Leistung und Rechengeschwindigkeit her das ganze Rechenzentrum der NASA bei der Mondladung 1969 ersetzen könnte.

Hilfe durch Signalprozessoren

Effektive Rauschfilterung erfordert eine sehr komplexe Mathematik. Diese in Algorithmen umzusetzen, ist ähnlich aufwendig, und nur Prozessoren können dies abarbeiten, die viele Rechenoperationen schnell abarbeiten können. Genau diese Signalprozessoren gibt es inzwischen. Sie sind in der Lage das einzelne Pixel mit einer immer größer werdenden Zahl von Umgebungspixeln zu vergleichen. Außerdem erkennen sie monochrome Flächen gleicher Helligkeit und erkennen statistische Abweichungen in diesen Flächen (in denen Rauschen besonders auffällt). So können sie es eliminieren.

Sie erkennen ebenso Farbsprünge, wenn zum Beispiel durch Rauschen in einer eher blauen Fläche plötzlich kleine rote oder grüne Punkte auftauchen würden, und sind in der Lage, diese Fehler wegzurechnen. Was die Kamera nicht schafft, bekommt man dann später am PC mit den noch leistungsfähigeren Prozessoren und den Algorithmen und vor allem den richtigen Filtern noch besser korrigiert.

Dazu kommt dann auch noch der Faktor Mensch. Diese Fehlerquelle ist am schwierigsten auszugleichen. Die Dateien und Bilder werden immer größer und werden immer noch oft auf Pixelebene am Monitor „bewertet“. Für das Foto selbst hat dieses Verfahren überhaupt keine Relevanz. Denn niemand wird sich im Normalfall nur einen Monitor großen Ausschnitt eines an sich quadratmetergroßen Fotos anschauen.

Verkleinern reduziert Rauschen. Druck von Fotos reduziert Rauschen. Du kannst bei unbewegten Motiven sogar mehrere Aufnahmen miteinander verrechnen und erhältst am Ende eine Aufnahme, die Du mit ISO 12.800 gemacht hast – und es so aussieht, als hättest Du sie mit ISO 200 gemacht.

Du siehst: Mit der richtigen Einstellung zu den Fotos ist Rauschen heutzutage wirklich kein (ernsthaftes) Problem mehr.

Fazit

Mir ist bewusst, dass ich vermutlich Widerspruch bekommen werde. Sowohl von den „Physikern“, die meine Darstellung als nicht exakt genug kritisieren werden, als auch von den Perfektionisten, die eben doch auf der 100%-Ebene vergleichen wollen.

Den Physikern sei gesagt: Ich habe das Thema studiert, allein das Thema Rauschunterdrückung hatte in meinem Vorlesungsskript über 100 Seiten. Mein Ziel ist es nicht, hier Elektronik-Ingenieure auszubilden, sondern nur ein grundlegendes Verständnis zu schaffen, daher die bildhafte Darstellung.

Den Perfektionisten sei gesagt: Jeder entscheidet für sich selbst, was er als erträglich empfindet. Und an alle anderen: Viel Spaß an Euren Fotos.

Ganz klasse Artikel, hat viel zu meinem Verständnis beigetragen!

Ich finde es immer sehr hilfreich, wenn bestimmte Zusammenhänge mit „Beispielen aus dem Leben“ verglichen werden (hier Eimer) (auch, wenn das nicht immer 100 %ig hinhaut). Aber so ist es besser nachzuvollziehen, Danke!

Ich schaue mal, ob mir die neuen Erkenntnisse helfen, das sehr starke Rauschen in mehr oder weniger einfarbigen Bereichen (war vorher nicht da) zu erklären und zu lokalisieren…

Gruß!

Kurz und bündig, sehr gut erklärt.SUPER

Ein wirklich erhellender Artikel, die Grundlagen der Sensortechnik sind sehr schön erklärt, und das „Rauschen“ präzise erläutert – sonst wird meist nur schwammig drumherum geredet. Vielen Dank!

Ich als Halbphysiker (abgebrochen) finde diesen Artikel wirklich sehr anschaulich und im Rahmen der Vergleiche im wesentlichen korrekt. Ist für mich zwar kaum Neues, da ich mich schon länger auch mit dem Thema beschäftigt habe (die Entwicklung über die Steigerung der Ladungsaufnahme-Fähigkeit der Sensorelemente hatte ich so nicht auf dem Schirm).

Bin gespannt auf die Fortsetzungen…

Vielen Dank für den verständlich formulieren Artikel. Das kleinere Sensoren rauschanfälliger sind als große erkläre ich mir jetzt damit, dass ja die „Eimer nicht so groß sind“, die Lichtteilchen jedoch immer gleich dimensioniert sind.

Ist das so korrekt?

Ja, in etwa, wenn Du noch dazu folgendes Bild nehmen würdest: dadurch, dass die Eimer dichter nebeneinander stehen, fallen die Lichtteilchen auch öfter mal in den falschen Eimer, der direkt daneben steht.

sehr ausführlich und gut verständlich erklärt.

vielen Dank dafür…LG Bijane

Gut erklärt, Daumen hoch !

Guter Artikel, ohne Schnörkel !

Für weiteres zum Thema würde mich interessieren (das konnte ich jetzt hier nicht ableiten), wie sich das Rauschen zur Lichtmenge verhält. Bei gutem Tagesslicht rauscht eine Aufnahme bei xx.000 ISO ganz wenig, manchmal nimmt aber störendes Rauschen bei 100 ISO und „normalen“ Lichtverhältnissen wahr – warum? … Danke Tom

Super gut beschrieben! Danke für den Artikel. Bin schon gespannt auf die weiteren Folgen zur Bildbearbeitung!

Danke herzlich da kann ich recht viel lernen, das ist wieder mal ein “ super Artikel“, Dankeschön dem Verfasser.

Vielen Dank für den sehr wertvollen Artikel.

Ich füge ihm noch hinzu: mich stört das Rauschen nicht immer; manchmal gar gefällt es mir in einem gewissen Bild-Kontext, so dass ich ein Bild absichtlich etwas rauschen lasse :-) und selten gar füge ich zu einem Bild mithilfe Photoshop ein dezentes Rauschen hinzu … ! – Herzlich – Martin Messmer

Guter Artikel und sehr verständlich geschrieben.

Ich freue mich auf weitere Abhandlungen zu dem Thema insbesondere auf praktische Tipps zur weiteren Bearbeitung dunkler Bilder mit Rauschen.

…auch aus Sicht der Quantenphysik verständlich beschrieben.

Denn um nichts anderes geht es ja hierbei :-)

Endlich blicke ich durch, für Otto-Normalverbraucher leicht verständlich geschildert!

Der Artikel hat mir gut gefallen. Ich hab schon einiges ausprobiert, Rauschen zu minimieren. Etwas heller belichten, später das Foto etwas abdunkeln und dann verkleiner. Diese Methode ist einfach und bringt schon einiges. Ich bin kein Freund von aufwendiger Bildbearbeitung. Aber gern würde ich hier lesen, wie man Wolken dramatisch hervorheben kann, ohne Paintshop od. ähnlichen … . Gruß an die Redaktion

Das kommt auf die Umstände an. Oft helfen Filter. Zu nennen sind da Verlaufs- oder/und Polarisationsfilter. Es kommt aber drauf an wie stark sich die höchste und geringste Helligkeit im Motiv abbilden. Manchmal hilft nur die Verrechnung von unterschiedlich belichteten Fotos (HDR/HDRI). Dies wurde schon zu analogen Zeiten in der Dunkelkammer gemacht (komplexes Unterfangen) und ist heute per Software viel einfacher, aber im Grunde ist das Analoge und Digitale das gleiche. Schreib doch mal spezifischer, wann und wie Du dies umsetzen möchtest. Wenn Du Mitglied der fotocommunity bist, kannst Du auch ein beispielhaftes Bild hochladen und hier per Link einbringen.

Bei SW-Fotos waren zu analogen Zeiten Gelb- oder Rotfilter das Mittel der Wahl..

Sehr gut und allgemein verständlich formuliert. Prima!