Auf Deine Leseliste in Meine Fotoschule setzen

Auf Deine Leseliste in Meine Fotoschule setzenIn Zusammenarbeit mit

In meinem letzten Beitrag über den richtigen Einsatz von AF-Feldern habe ich schon angedeutet, dass ich einen weiteren Teil schreiben werden, bei dem ich Dir erkläre, wie in bestimmten Situationen der Autofokus und die Belichtungsmessung zusammenarbeiten.

Einfach fotografieren lernen mit unseren Online-Fotokursen

Für nur 6,99€ im Monat kannst Du auf über 70 Online-Fotokurse zugreifen. Lerne die Grundlagen der Fotografie - verständlich und mit vielen Praxisbeispielen. Inklusive Test und Fotokurs-Zertifikat.

Mehr Infos zu den Fotokursen

Bei Systemkameras und fast allen spiegellosen Systemen ergibt sich dies automatisch dadurch, dass sowohl die Schärfe- als auch die Belichtungsmessung letztendlich über den Sensor erfolgen und daher der Zusammenhang beider Messungen sich rein logisch ergibt. Trotzdem sollte es sich auch dann für Dich lohnen, diesen Artikel zu lesen, weil bestimmte Zusammenhänge auch für spiegellose Kameras gelten und es sich daher in vielen Teilen um rein grundsätzliche Zusammenhänge handelt.

Spiegelreflexkameras haben dagegen drei unterschiedliche Sensoren:

- den eigentlichen Bildsensor zur Aufzeichnung des Fotos

- einen AF-Sensor zur Schärfemessung

- und einen AE-Sensor (AE = Auto-Exposure – engl. für Belichtungsmessung).

Im Grunde arbeitet jeder der drei Sensoren für sich völlig unabhängig voneinander.

Die Sensoren

Ist der Spiegel unten und der mechanische Verschlussvorhang geschlossen (Du kannst durch den optischen Sucher ein Bild sehen), dann ist der eigentliche Bildsensor natürlich blind. Er kann also nichts zu den Messungen der Belichtung beitragen. Der Schärfesensor und der Belichtungssensor müssen also irgendwie miteinander kommunizieren.

Dazu werfen wir einen Blick auf die verschiedenen Sensortypen und betrachten den grundsätzlichen Aufbau. Dieser Aufbau kann sich von Modell zu Modell unterscheiden, die Unterschiede sind für die folgenden Betrachtungen allerdings nicht bedeutend bezüglich der prinzipiellen Funktionsweise. Die Unterschiede kommen erst bei erweiterten Funktionen der Zusammenarbeit beider Sensoren zum Tragen (darauf gehe ich am Ende noch ein).

Der AE-Sensor (Belichtung)

Die ersten Belichtungssensoren konnten genau eine Aufgabe erfüllen: die Belichtung messen. Dabei wurde nicht unterschieden wo und an welcher Stelle gemessen wurde. Die Messung bezog sich auf den Mittelwert des gesamten erfassten Bereichs. Die Messung war nicht in der Lage zwischen hellen und dunklen Bereichen des Motivs zu unterscheiden.

In häufigen Fällen hat diese Messform trotzdem funktioniert, da die Mittelwerte aus der Gesamtfläche des Sucherbereiches trotzdem eine gute Messung ergeben haben, die zu einer korrekten Belichtung führten. Zur Erinnerung: Der Mittelwert und die Eichung der Belichtungsmessung orientiert sich am Wert 18% Grau, was aufgrund der logarithmischen Darstellung genau einem 50%igen Mittelwert entspricht.

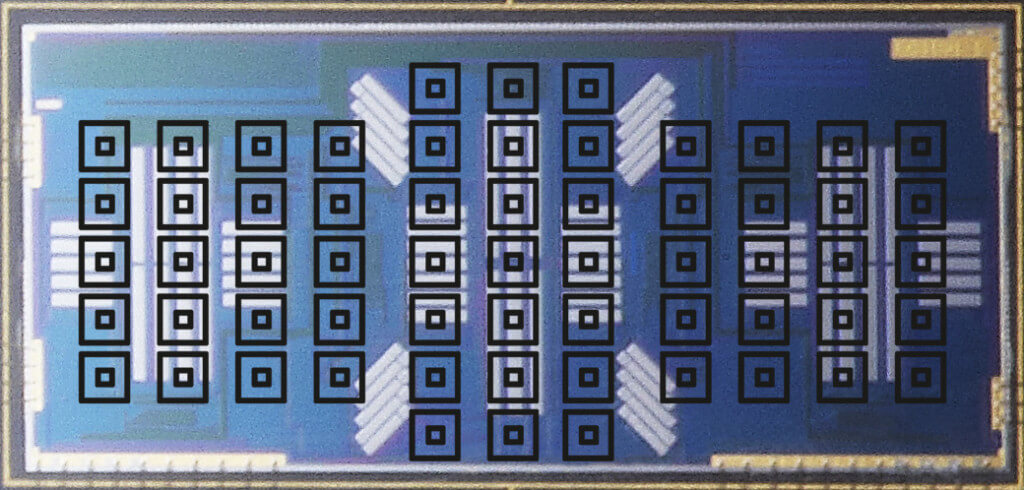

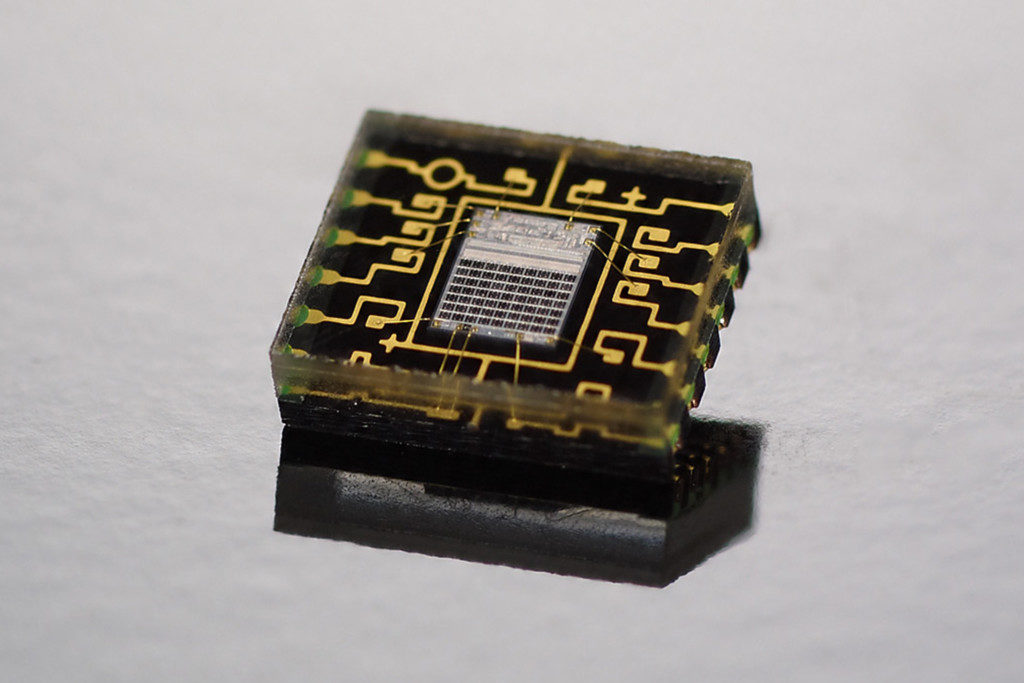

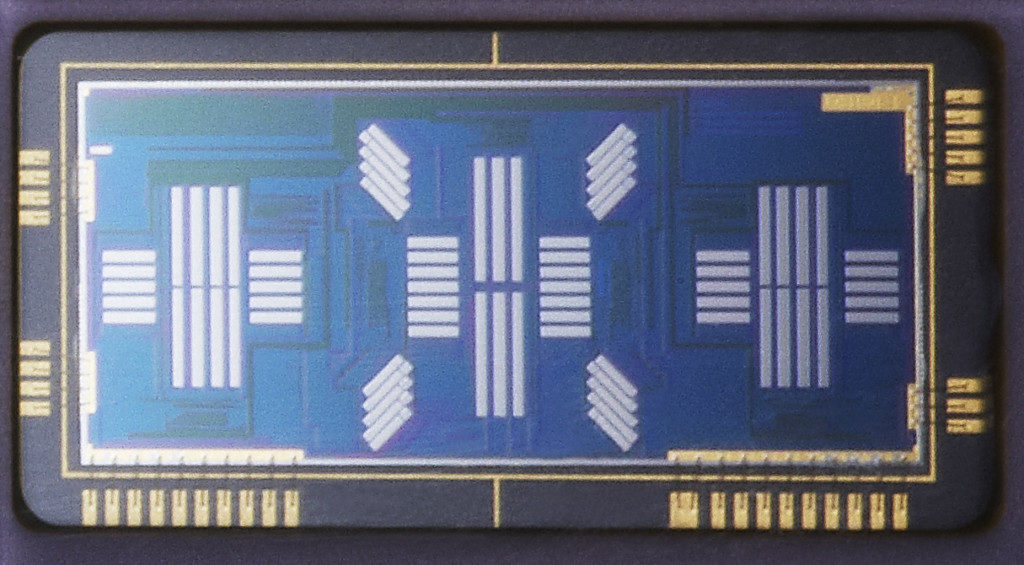

Im Laufe der Jahre wurde es möglich die AE-Sensoren feiner zu gestalten. Heutzutage ist es möglich, dass die AE-Sensoren den Bereich, der gemessen wird, in Felder bzw. Zonen unterteilen. Nachfolgend habe ich Dir ein paar Bilder solcher AE-Sensoren herausgesucht, die heutzutage noch verwendet werden (auch wenn nicht alle davon noch produziert werden).

Störe Dich bitte weder an der Bezeichnung der Generation (es gab sicher noch frühere Generationen von Sensoren), noch an der Tatsache, dass es sich um Sensoren von Canon handelt. Ich bin in dieser Welt groß geworden. Die Sensoren anderer Firmen arbeiten prinzipiell gleich.

- Generation

In diesem Fall hat der Sensor 35 Messfelder, die sich über einen Großteil des Sucherbildes verteilen und es sozusagen in 35 Zonen aufteilen, die jede für sich über eine Mittelwertbildung gemessen werden. Diese Sensorgeneration ist schon in gewissen Grenzen in der Lage spezielle Situationen, wie zum Beispiel Gegenlicht zu erkennen und darauf zu reagieren. Es wird aber rein die Helligkeit gemessen, Farben finden keine Berücksichtigung. - Generation

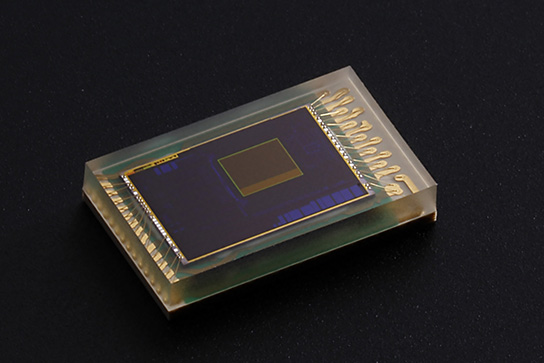

In der zweiten Generation ist die Zahl der Messfelder nahezu verdoppelt worden. Es ist eine feinere Aufteilung der Zonen möglich, was der Motiverkennung schon ein wenig entgegenkommt. Zudem wurde in dieser Generation eine gewisse Farbempfindlichkeit implementiert. Die Sensoren besitzen eine wechselweise Rotgrün- und Blaugrün-Empfindlichkeit. Die Sensoren erkennen damit noch keine Farbmuster, sind aber schon in der Lage Farbclipping zu erkennen (Rot ist dafür besonders anfällig) und darauf zu reagieren. - Generation

Die Unterteilung wird deutlich feiner. Der Sensor ist in der Lage insgesamt 63 Zonen zu messen und ist vor allem als RGB-Sensor ausgelegt und misst auch Infrarot. Durch die Auflösung von rund 8000 Pixeln ist neben der genaueren Messung der einzelnen Zonen auch erste Muster- und Motiverkennung möglich. In gewissen Grenzen sind diese Sensoren in der Lage auch Gesichter zu erkennen. - Generation

In der aktuellsten Generation haben moderne Belichtungssensoren bis zu 350.000 Pixel (RGB und IR), die in manchen Fällen von einem eigenen Bildprozessor ausgewertet werden und deren Zoneneinteilung nochmals deutlich feiner ist. Diese Generation an AE-Sensoren erlaubt eine umfangreiche Muster-und Farberkennung. Es können Motive und Lichtsituationen erkannt werden, die Gesichtserkennung arbeitet sehr präzise.

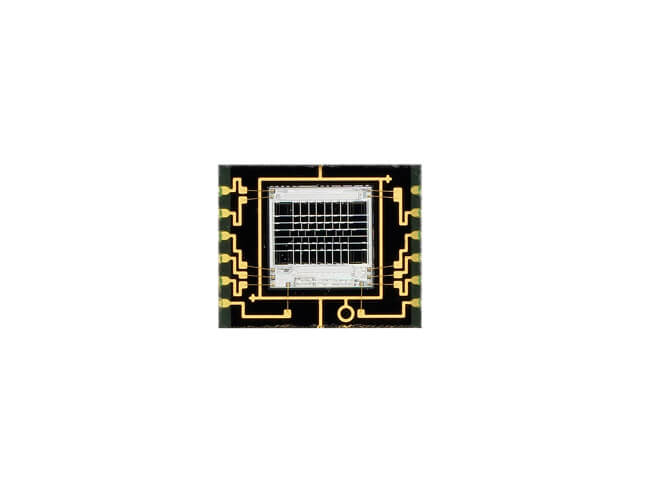

Die AF-Sensoren

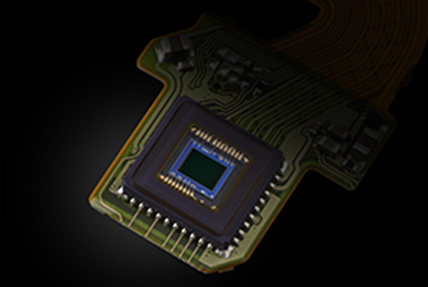

Diese Sensoren muss ich nicht so umfangreich erklären, wie die unterschiedlichen AE-Sensoren. Deren grundsätzliche Funktion haben wir schon in einigen früheren Artikeln genauer erläutert. Folgend zeige ich Dir einige unterschiedliche AF-Sensoren, die in heutigen Kameras verwendet werden.

(Fotos: Canon)

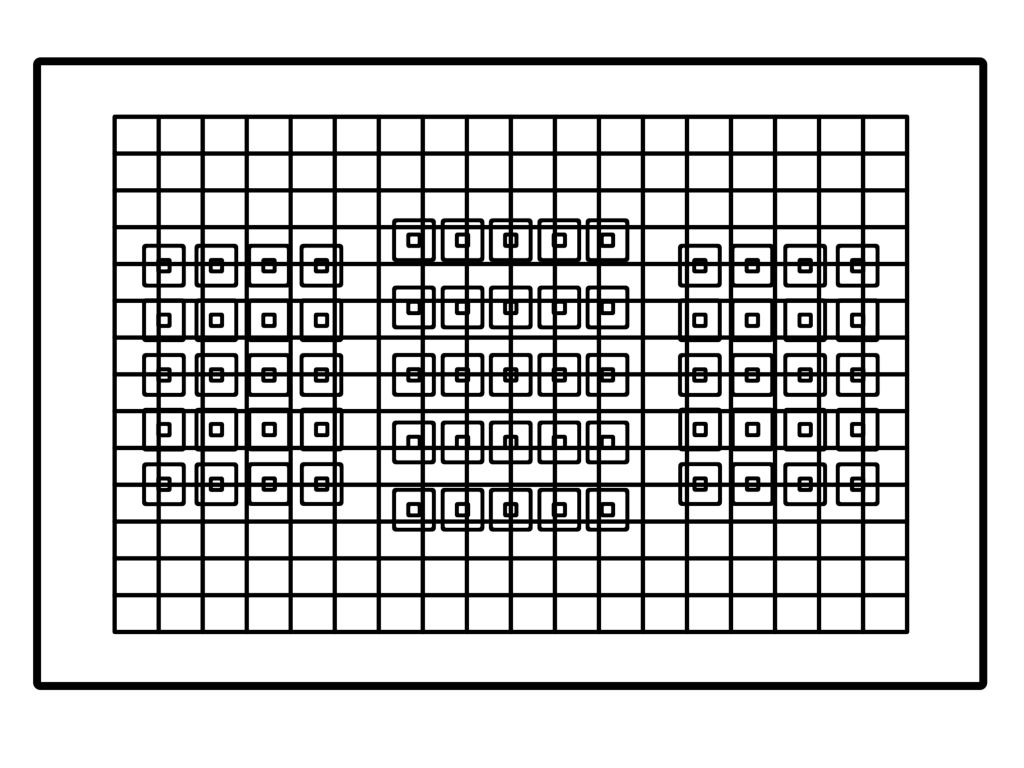

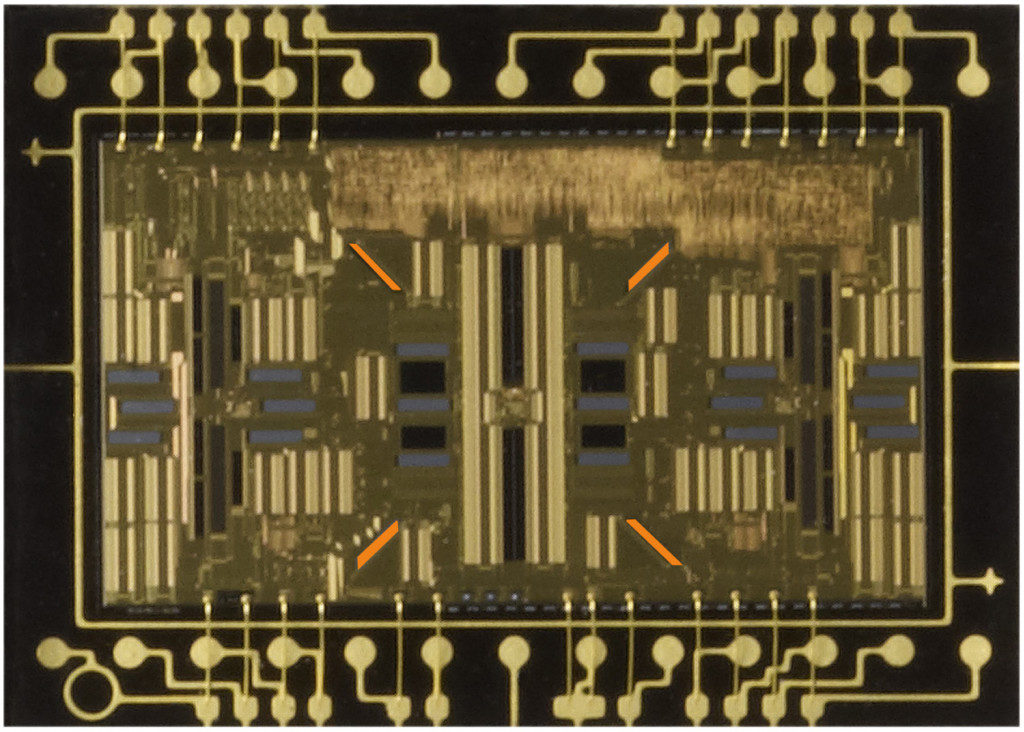

Für diesen Artikel ist die genaue technische Funktion tatsächlich auch nicht wichtig. Wichtig für die Zusammenarbeit von Belichtungsmessung und Autofokus ist die Anzahl und Verteilung der Felder. Genau wie die Zonen der Belichtungssensoren sind die Felder der AF-Sensoren über den gesamten Sucherbreich verteilt. Um dies zu erläutern, habe ich die Zonen und die AF-Felder einer Kamera beispielhaft übereinandergelegt. Anhand dieser etwas grafischen Darstellung erkennst Du, dass man jedem AF-Feld eine oder mehrere Messzonen der Belichtungszonen zuordnen kann.

Die Formen der Zusammenarbeit

Nicht in allen Fällen gibt es zwischen dem Autofokus und der Belichtungsmessung ein Miteinander. Erinnern wir und dafür an die unterschiedlichen Messmethoden zur Belichtungsmessung:

- Matrix- oder Mehrfeldmessung

- Spotmessung

- Selektivmessung

- Integralmessung

Die beiden letzten Verfahren messen definierte Zonen im Sichtfeld des Suchers und arbeiten unabhängig vom Autofokus. Bei der Spotmessung kann es eine Verknüpfung mit dem Autofokus geben (meist größeren Kameramodellen vorbehalten), bei der Mehrfeld- bzw. Matrixmessung ist sie eigentlich immer vorhanden.

Mehrfeld- oder Matrixmessung und der Autofokus

Bei der Matrixmessung wird jede Zone für sich gemessen. Egal, ob es nun 35, 63 oder 252 Zonen sind (oder sogar eine ganz andere Zahl). Jede Zone für sich liefert ein Ergebnis, das in die Gesamtbewertung der Lichtsituation einfließt. Je nach Komplexität erkennt der Belichtungsmesser dabei durchaus bestimmte Situationen (Gegenlicht, Schneelandschaften usw.) und versucht auf die Situationen durch Korrekturen bezogen auf die Abweichung vom Mittelwert zu reagieren.

Zusätzlich erhält der Belichtungsmesser vom Autofokus weitere Informationen. Wie aus den vorhergehenden Bildern zu sehen ist, kann die Lage der Fokusfelder den Zonen der Belichtungsmessung zugeordnet werden. Je nachdem, ob Du nun alle Felder, Zonen oder Einzelfelder nutzt, gibt es ein oder mehrere Felder, die einen Fokus finden.

Du musst Dir nun vorstellen, dass das oder die AF-Felder, die einen Fokus gefunden haben, sich beim Belichtungsmesser „melden“. Sie melden, dass sie das Motiv scharf gestellt haben und an welcher Position sie liegen. Nun passiert Folgendes: Die Belichtungsmessung weiß nun, an welcher Stelle das Bild fokussiert wurde und kennt die Messergebnisse an dieser Stelle. Das System geht jetzt davon aus, dass an den Stellen, wo der Fokus liegt, sich auch das Hauptmotiv befindet.

Die Zonen, in denen der Fokus liegt, bekommen bei der Bewertung der Messung ein höheres Gewicht (sozusagen einen Multiplikator). Der Belichtungsmesser bewertet damit die fokussierten Bereiche des Bildes höher, als die anderen gemessenen Bereiche. Diese fließen dann stärker in das Gesamtergebnis der Messung ein.

Wie musst Du Dir dies vorstellen? Ich versuche es an einem Beispiel zu erklären:

Wenn Du eine Gruppe Menschen vor einem sehr dunklen Hintergrund fotografierst, würde eine nicht gewichtete Messung dazu führen, dass die Gesichter stark überbelichtet werden, da der dunkle Hintergrund den Mittelwert, auf den der Belichtungsmesser geeicht ist, nach unten zieht. Durch die Gewichtung wird die Belichtung nach unten korrigiert. Die Gesichter stehen im „Fokus“ der Messung.

Spotmessung und der Autofokus

Die Spotmessung begrenzt den gemessenen Teil auf einen sehr begrenzten Teil des Sucherbereichs (dieser Bereich umfasst normalerweise 2-3% des gesamten Sucherfeldes). Die Spotmessung wird gern in sehr schwierigen Lichtsituationen eingesetzt, so zum Beispiel in der Bühnenfotografie (Theater/Konzert) und auch oft für Reportagen. Sie sorgt dafür, dass das bildwichtige Element korrekt belichtet wird, ohne dabei die Umgebung zu berücksichtigen.

In vielen Fällen (bei Nikon öfter als bei Canon) kann die Spotmessung an das verwendete AF-Feld geknüpft werden. Wenn Du also das einzelne AF-Feld verschiebst, verschiebt sich auch der Bereich der Spotmessung auf den Punkt, den Du fokussierst und hast so die Belichtungsmessung immer genau im „Fokus“.

In den bisher genannten Fällen unterstützt der Autofokus die Belichtungsmessung. Es gibt aber auch umgekehrte Fälle, bei denen der Belichtungsmesser dem Autofokus hilft. Zu diesen Fällen kommen wir jetzt.

Gesichtserkennung und Autofokus

Bei der bildsensorbasierten Schärfemessung während des Livebildes ist die Gesichtserkennung schon lange bekannt. Betrachtest Du aber den Aufbau eines AF-Sensors (für den Phasen-AF) sollte schnell klarwerden, dass der AF-Sensor aufgrund seines Aufbaus nicht in der Lage ist Strukturen zu erkennen, geschweige denn Gesichter. Auch die ersten beiden Generationen der AE-Sensoren, die ich oben genannt habe, lösen nicht fein genug auf, um Motive, Gesichter oder Strukturen zu erkennen.

Erst ab der dritten Generation ist eine Mustererkennung möglich. Im Falle der vierten Generation sogar in hoher Qualität. Der AE-Sensor misst also nicht nur die Helligkeit, sondern sucht auch nach bestimmten Strukturen, die einem Gesicht ähneln. Wie einfach diese Struktur gestrickt ist, kannst Du selbst ausprobieren, indem Du einfach ein Hühnerei nimmst und ein Smiley darauf malst. Meist interpretiert der Belichtungsmesser dies auch als Gesicht.

Der AE-Sensor erkennt die Position des Gesichts innerhalb des Sucherbereichs und gibt diese Information an den Autofokus weiter. Der Autofokus wiederum aktiviert die positionsgleichen AF-Felder und misst die Schärfe dort. Bewegt sich das Gesicht innerhalb des Sucherfelds, verfolgt der AF mit Hilfe der Informationen des AE-Sensors das Gesicht weiter und hält es auch dann im Fokus, wenn an anderer Stelle Objekte im Sucherfeld auftauchen, die näher zur Kamera stehen und ansonsten zu einem Fokuswechsel führen.

Erkennen komplexer Farbmuster und Strukturen und der Autofokus

Die bisher komplexeste Form der AF-Steuerung ist das intelligente Tracking von Motiven. Aus dem vorigen Teil weißt Du noch, dass bei großen Zonen und „Allen Feldern“ die Messergebnisse der Felder verglichen werden und der AF ggf. die Felder wechselt und in gewissen Grenzen Störungen ignoriert. Dieses Verfahren hat aber seine Grenzen, wenn viele Störungen auftreten und die Bewegungsmuster sehr komplex sind.

Hochauflösende AE-Sensoren kommunizieren wechselseitig mit dem Autofokus. Der AF meldet an den AE-Sensor die Position des fokussierten Objekts. Der AE-Sensor erfasst Farbe, Form und Struktur des Ziels. Wenn Du nun den Sucherausschnitt veränderst oder das Motiv sich im Sucher bewegt, dann bleibt der AF sozusagen am Ziel und wechselt die AF-Felder nach Bedarf, selbst wenn die Richtung der Bewegung sich ändert.

Um Dir die Funktion zu erläutern, zeige ich Dir an dieser Stelle zwei Videos:

Canon:

Nikon:

Nach Ansehen der Videos solltest Du die Funktion nun verstanden haben und einsetzen können.

Fazit

Viele Fokusfehler entstehen, weil Du Dich nicht ausreichend mit den Möglichkeiten Deiner Kamera beschäftigt hast oder weil Du versehentlich oder unbewusst eine Funktion aktiviert hast, die Du in Deiner Motivsituation gar nicht gebrauchen kannst. Diese kleine Serie sollte Dir helfen, diese Fehler zu vermeiden und Deine Kamera besser zu beherrschen.

Nachdem wir die Grundlagen zur AF-Funktion gelegt haben, werden wir uns in weiteren Artikeln mit speziellen Formen der Fokussierung beschäftigen.

Ob folgendes bei allen Spiegelreflex-Kameras so ist, weiss ich nicht, jedoch:

Wenn ich bei meiner Canon die Spotmessung gewählt und nur das mittlere AF-Feld aktiviert habe, damit ein Objekt fokussiere und danach wegschwenke mit gedrückter Auslösetaste um einen anderen Bildausschnitt zu erhalten, muss der AE-Speicher getätigt werden. Ansonsten misst meine Kamera immer noch genau die Mitte und nicht das unterdessen verschobene, scharf gestellte Objekt.

Vielleicht ist dies noch eine kleine Ergänzung, sofern ich nicht komplett falsch liege?

Du hast Recht. Dies gilt allerdings für alle Methoden der Belichtungsmessung und nicht nur Spot. Bei der Spotmessung sind die Auswirkungen meist am deutlichsten. Die Messwertspeicherung gehört zu den fortgeschrittenen Belichtungstechniken, hat aber mit dem Autofokus nichts zu tun, daher wurde sie nicht erwähnt.

Ein sehr hilfreicher Artikel. Besten dank dafür!!!!

Genau das habe ich gesucht. Die Bedienungsanleitung meiner Kamera (Canon 6d) gab da nicht viel her. Bei nur 11 AF-Sensoren, wovon nur einer ein Kreuzsensor ist, dürfte da aber auch nicht viel möglich sein.

Mit meiner neuen 5dM4 dürfte das deutlich besser gehen.

6.12.2017

doll,solche einfachen Infos.kurz,genau und verständlich,bitte sollche grundlageninfos weiter soo..-besten dank jörg eberl